Enthüllung der Crawl-Statistiken von Google Search Console: Ein verstecktes Juwel für SEO-Profis

Im Bereich der SEO können die von Branchenexperten eingesetzten Tools maßgeblich beeinflussen, wie effektiv eine Website indexiert und gerankt wird. Ein solches Tool, das oft unter dem Radar fliegt, sind die „Crawl-Statistiken“ von Google Search Console. Für diejenigen, die sich auf Websites im großen Maßstab bewegen, kann das Verständnis dieses Features kritische Einblicke in das Crawling-Verhalten von Googlebot ermöglichen, was in standardmäßigen SEO-Praktiken oft übersehen wird.

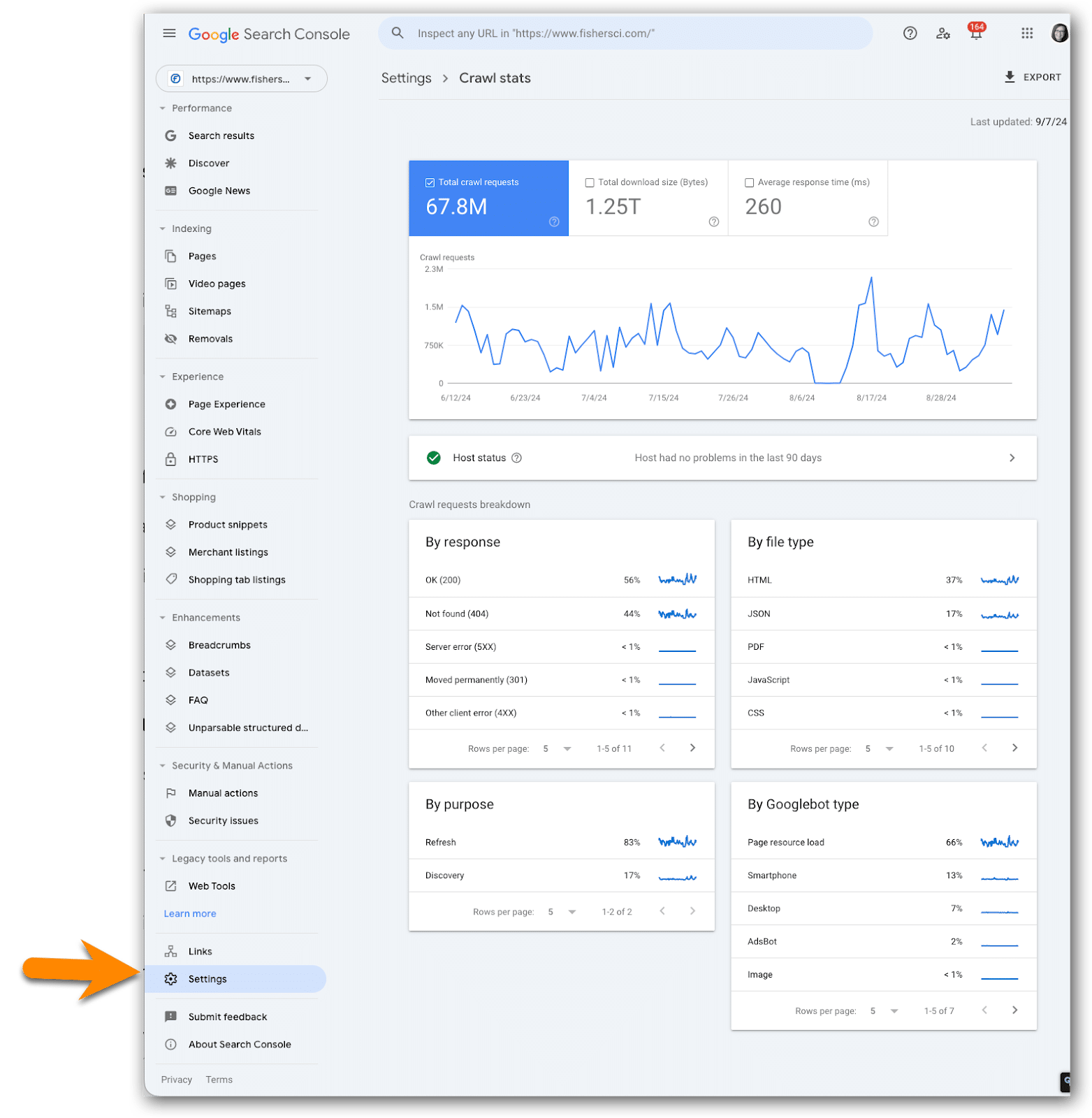

Zugriff auf Crawl-Statistiken

Um von den umfangreichen Informationen von Crawl-Statistiken profitieren zu können, sollten Benutzer zunächst zum Einstellungen-Bereich in der Google Search Console navigieren und den Crawl-Statistiken-Bericht aufrufen. Dieser Bericht bietet einen Überblick über die Aktivitäten von Googlebot auf einer Website und enthält detaillierte Daten, die fortgeschrittene Benutzer aufgrund der möglichen Komplexitäten als unschätzbar wertvoll erachten könnten.

Der Wert von Crawl-Statistiken für Unternehmen

Dieser Bericht ist nicht nur ein Luxus für größere Organisationen; er kann als Lebensader für SEO-Profis auf Unternehmensebene dienen, die möglicherweise keinen Zugang zu ausgefeilten Crawling- und Überwachungslösungen haben. Für kleine Websites, während der unmittelbare Bedarf an der Überwachung der Crawler-Aktivität aufgrund angemessener Crawl-Budget-Zuweisungen weniger dringend sein mag, kann es langfristig dennoch einen Wettbewerbsvorteil bieten, diese Metriken im Auge zu behalten.

Wichtige zu überwachende Kennzahlen

Es ist für Fachleute entscheidend, sich auf wechselnde Kennzahlen zu konzentrieren, wie z.B. HTML-Anomalien bei Anforderungen, Download-Größen und Antwortzeiten. Diese können wichtige Einblicke liefern, die für strategische Entscheidungen entscheidend sind, insbesondere wenn auffällige Unregelmäßigkeiten auftreten. Eine kontinuierliche Überwachung – idealerweise monatlich, insbesondere nach wesentlichen Website-Updates – kann ein klareres Bild davon vermitteln, wie Googlebot mit den Änderungen auf der Website interagiert, und so eine proaktive Optimierung ermöglichen.

Protokollierung und Verfolgung für langfristigen Erfolg

Angesichts des begrenzten zeitlichen Rahmens, den die Berichte von Google bieten, wird empfohlen, eine Tabelle mit Daten zu Crawl-Statistiken zu erstellen. Dies ermöglicht es Fachleuten, wichtige Kennzahlen im Laufe der Zeit zu verfolgen, wie z.B. die Gesamtzahl der Crawl-Anforderungen und die durchschnittliche Antwortzeit, und fördert informierte Diskussionen mit Entwicklern, wenn Probleme auftreten. Der historische Kontext kann strategische SEO-Initiativen effektiv lenken.

Integration von Crawl-Statistiken in URL-Management-Strategien

Darüber hinaus ist es beim Analysieren von Crawldaten entscheidend, deren Schnittpunkt mit URL-Kürzern und Link-Management zu berücksichtigen. URL-Kürzer können den Crawling-Prozess optimieren und das Tracking der Link-Performance verbessern. Durch das Protokollieren dieser Erkenntnisse neben den Crawldaten können Fachleute ein besseres Verständnis dafür gewinnen, wie URL-Strukturen die SEO-Ergebnisse beeinflussen. Tools wie #LinksGPT und #UrlExpander können bei diesem Prozess helfen, die Effektivität von Links und den Traffic-Fluss zu optimieren.

Abschließend wird SEO-Experten und Digital Marketern empfohlen, einen systematischen Ansatz zur Überwachung von Crawl-Statistiken zu entwickeln. Durch die Aussicht auf weitere Einblicke in Folgeartikeln könnte die Nutzung dieses oft übersehenen Features signifikante ROI in SEO-Strategien bringen.

#SEO #GoogleSearchConsole #CrawlStats #BitIgniter #LinksGPT #UrlExpander #UrlShortener

Mehr erfahren: Weiterlesen