Découverte des statistiques de crawl de Google Search Console : un joyau caché pour les professionnels du SEO

Dans le domaine du SEO, les outils utilisés par les experts de l'industrie peuvent avoir un impact significatif sur la manière dont un site web est indexé et classé. Un tel outil qui passe souvent inaperçu est les « Statistiques de crawl » de Google Search Console. Pour ceux qui naviguent sur des sites à grande échelle, comprendre cette fonctionnalité peut révéler des informations essentielles sur le comportement de crawl de Googlebot, une nécessité souvent négligée dans les pratiques standard de SEO.

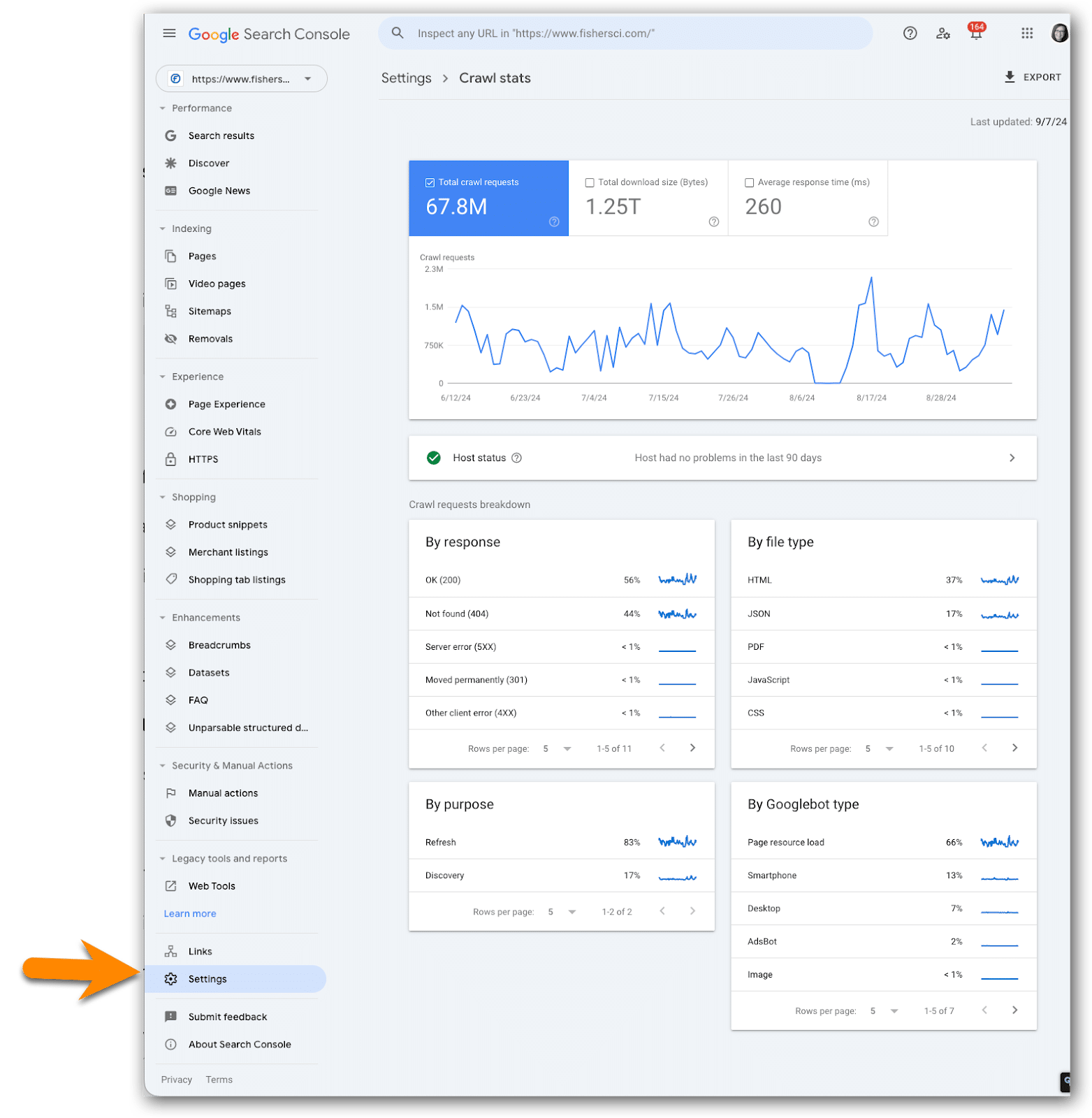

Accès aux statistiques de crawl

Pour accéder à la richesse d'informations fournies par les Statistiques de crawl, les utilisateurs doivent d'abord se rendre dans la section Paramètres de Google Search Console et accéder au rapport des Statistiques de crawl. Ce rapport présente un aperçu général de l'activité de Googlebot sur un site, présentant des données complexes que les utilisateurs avancés pourraient trouver inestimables en raison des complexités possibles.

La valeur des statistiques de crawl pour les entreprises

Ce rapport n'est pas simplement un luxe pour les grandes organisations ; il peut servir de bouée de sauvetage pour les professionnels du SEO de niveau entreprise qui pourraient ne pas avoir accès à des solutions sophistiquées de crawling et de surveillance. Pour les petits sites web, bien que le besoin immédiat de surveiller l'activité des crawlers puisse être moins pressant en raison d'allocations de budget de crawl adéquates, garder un œil sur ces métriques peut tout de même offrir un avantage concurrentiel à long terme.

Principaux indicateurs à surveiller

Il est essentiel pour les professionnels de se concentrer sur des métriques fluctuantes, telles que les anomalies des demandes HTML, les tailles de téléchargement et les temps de réponse. Celles-ci peuvent fournir des informations cruciales pour les décisions stratégiques, surtout en cas d'irrégularités notables. Une surveillance régulière - idéalement mensuelle, en particulier après des mises à jour importantes du site web - peut donner une image plus claire de l'interaction de Googlebot avec les changements du site, permettant une optimisation proactive.

Journalisation et suivi pour un succès à long terme

Compte tenu de la durée limitée des rapports de Google, il est fortement recommandé de créer un journal des données de Crawl Stats dans un tableur. Cela permet aux professionnels de suivre des métriques cruciales dans le temps, telles que le nombre total de demandes de crawl et le temps de réponse moyen, favorisant des discussions informées avec les développeurs en cas de problèmes. Le contexte historique peut guider efficacement les initiatives SEO stratégiques.

Intégration des Crawl Stats avec les stratégies de gestion des URL

De plus, lors de l'analyse des données de crawl, il devient essentiel de considérer son intersection avec les raccourcisseurs d'URL et la gestion des liens. Les raccourcisseurs d'URL peuvent rationaliser le processus de crawl et améliorer le suivi des performances des liens. En enregistrant ces informations en parallèle des données de crawl, les professionnels peuvent mieux comprendre comment les structures d'URL affectent les résultats de SEO. Des outils comme #LinksGPT et #UrlExpander peuvent aider dans ce processus, optimisant ainsi l'efficacité des liens et le flux de trafic.

En conclusion, les professionnels du référencement SEO et les spécialistes du marketing numérique sont encouragés à développer une approche systématique pour surveiller les statistiques d'exploration. Avec la perspective de dévoiler de plus amples informations dans des articles ultérieurs, tirer parti de cette fonctionnalité souvent négligée pourrait générer un retour sur investissement significatif dans les stratégies de référencement.

#SEO #GoogleSearchConsole #CrawlStats #BitIgniter #LinksGPT #UrlExpander #UrlShortener

Envie d'en savoir plus : Lire la suite